Rohstoff der Forschung

Weniger Datensilos, mehr Austausch – die Informatik-Forschung strebt nach einer neuen Datenkultur. Die dafür nötige Infrastruktur wird unter Projektleitung der UDE aufgebaut.

Von Birgit Kremer

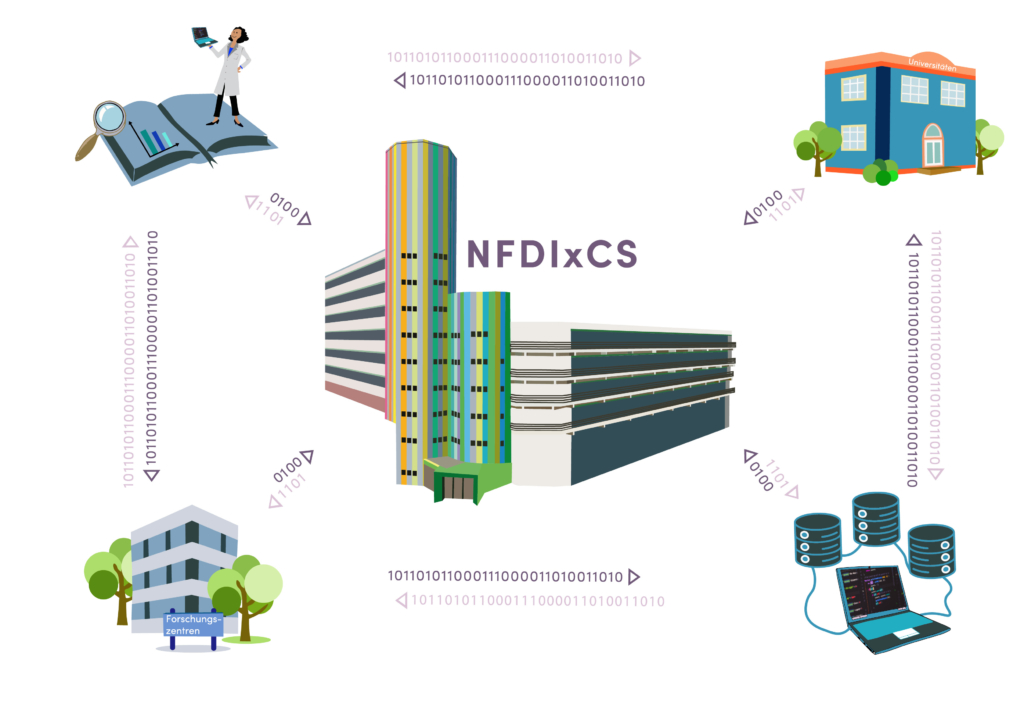

Forschungsdaten sind ein wertvolles Gut wissenschaftlicher Arbeit und zugleich Rohstoff für neues Wissen. Ihre Gewinnung ist mit Kosten und Mühe verbunden, doch ihr Potenzial wird in Deutschland nicht voll ausgeschöpft. Das gilt für die Informatik ebenso wie für andere Forschungsdisziplinen. Oft hat nur ein einzelnes Projekt-Team Zugriff auf die Datenbestände, dabei könnten sie auch für andere Forschende nützlich sein. „Was wir brauchen, ist die Möglichkeit, nicht nur Publikationen, sondern sämtliche Daten zugänglich zu machen, die in Forschungsprojekten erzeugt werden“, sagt Dr. Michael Goedicke. Der UDE-Professor vom Softwaretechnik-Institut paluno zählt mit seinem Informatik-Konsortium NFDIxCS zu den 27 Zusammenschlüssen, die eine Nationale Forschungsdateninfrastruktur (NFDI) aufbauen sollen.

Denn die Politik hat das Problem erkannt und mit der NFDI eine echte Innovation in der deutschen Wissenschaftslandschaft auf den Weg gebracht: Bis 2028 stellen Bund und Länder jährlich bis zu 90 Millionen Euro bereit, um Forschungsdaten nachhaltig zu sichern und nutzbar zu machen. Die nötige Infrastruktur soll den Universitäten und den außeruniversitären Einrichtungen wie beispielsweise Fraunhofer- und Leibniz-Instituten nicht vorgegeben, sondern von der forschenden Gemeinschaft selbst entwickelt werden. Dazu mussten Konsortien gebildet werden, die stellvertretend für ihre Disziplin sprechen und handeln können. Für NFDIxCS konnten Goedicke und seine Mitstreiter:innen rund 50 Partnerinstitutionen aus allen Zweigen der Informatik gewinnen.

VOM SUPERCOMPUTING BIS MEGAPROJEKT

Doch was sind eigentlich die ureigenen Forschungsdaten der Informatik? Klar ist: Die Daten sind so divers wie die Forschungsfragen der Informatik selbst. Die Technische Informatik erforscht die Leistungsfähigkeit von PCs und Supercomputern; dementsprechend wichtig sind hier die Ergebnisse von Leistungsmessungen. Die Mensch-Computer-Interaktion hingegen interessiert sich weniger für das Innere der Computer, sondern dafür, was sich zwischen Menschen und Maschine abspielt. Hier kommen häufig Probandenstudien zum Einsatz, die mitunter große Mengen an datenschutzrechtlich sensiblen Bild- und Tonaufnahmen hervorbringen. In anderen Zweigen der Informatik ist Software nicht nur ein Werkzeug, sondern selbst Gegenstand des Interesses. So etwa in der Softwaretechnik, die sich mit der Gestaltung softwareintensiver Anwendungssysteme und der Organisation großer Softwareprojekte befasst.

Bei all den Unterschieden müssen also gemeinsame Standards her. Das beginnt bei der einheitlichen Beschreibung mit Metadaten, die benötigt werden, damit Forschungsdaten gefunden werden können. Ebenso wichtig ist es, stabile und zukunftssichere Strukturen zu schaffen. Neben den Informatik-Instituten sind daher große Rechenzentren an Bord des Konsortiums. Sie bringen nicht nur Expertise und Rechenpower ein, sondern können dafür sorgen, dass die neuen Infrastrukturen nach Auslaufen der Förderung bestehen bleiben.

ZEITKAPSEL FÜR FORSCHUNGSDATEN

Ob und wie Forschungsdaten auch in Zukunft nutzbar sind, hängt darüber hinaus von der richtigen Software ab. Wer schon einmal ein Word-Dokument mit einer anderen Version des Textverarbeitungsprogramms geöffnet hat, kennt das Phänomen: Formatierungen gehen verloren und Bilder tauchen an unerwarteten Stellen im Text auf. Diese Problematik besteht auch bei der Verarbeitung scheinbar unkomplizierter Formate wie bei csv-Dateien, in denen Messwerte ohne Formatierung oder weitere Angaben zur Bedeutung der Daten gespeichert werden. So kann es bei der Verarbeitung mit verschiedenen Versionen passieren, dass Messwerte unterschiedlich gerundet werden. Allgemein gilt daher, dass Reproduzierbarkeit für Forschungsdaten nur gewährleistet werden kann, wenn auch später noch exakt die gleiche Softwarevesion zur Verfügung steht, mit der sie erzeugt wurden.

Das NFDIxCS-Konsortium will deshalb neben den Forschungsdaten alles, was zur Nutzung einer bestimmten Softwareversion nötig ist, in einer Art Zeitkapsel konservieren, Research Data Management Container (RDMC) genannt. Dazu gehören u.a. das Betriebssystem und verwendete Programmbibliotheken. Auch für den Schlüssel zur Kapsel werden Lösungen erarbeitet, sodass Forschende jederzeit und unabhängig von ihrer Institutszugehörigkeit Zugriff bekommen können – nach transparenten Zugriffsrechten und in Einklang mit dem Datenschutz.

Neben der Technik ist aber vor allem der Faktor Mensch entscheidend für den Erfolg der NFDI. Goedicke hat hier eine ganz bestimmte Gruppe im Blick: „Die meiste Arbeit und die eigentliche Kraft der Forschung geht vom wissenschaftlichen Nachwuchs aus“, meint er. „Daher wollen wir gezielt Studierende und Promovierende im Umgang mit Forschungsdaten schulen.“ Mit dem Bewusstsein für nachhaltiges Datenmanagement sollen sie in ihrem Umfeld wirken und handeln. Denn: Eine neue Datenkultur muss gelebt werden, sonst nützt die beste Technik nichts.

Die NFDI soll die Datenbestände von Wissenschaft und Forschung systematisch erschließen, nachhaltig sichern und (inter-)national zugänglich machen. Das von der UDE geleitete Konsortium NFDIxCS steht für Nationale Forschungsdateninfrastruktur für und mit Computer Science.

Titelbild: © unsplash